「SEO関連」記事一覧

謎:GSでAMPの認識が突如消える。

2020/03/07

一部の顧客で見られる現象。まだ確信をもっていないのでなんともはっきりしたことは言えないが、今年の1月上旬頃まではAMPページを沢山認識していたサイトが1月の中旬頃から突如90%以上認識が消失してしまうという問題。AMP文法エラーも出ておらず、AMPリファレンスのタグも既存コンテンツに付いているのに消えてしまった。どう調べてもコンテンツには問題がない。でも認識が激減で困ったもんだ。問題に対し浮かび上...

最近多いWhois問題、みなさんもDNS管理プロバイダーからの注意喚起のメールはよく読みましょうね!

2019/12/25

2020/05/26

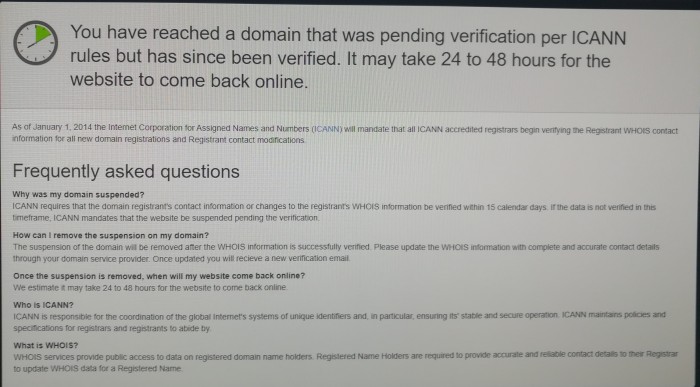

最近多いWhois問題ですが、whoisの情報がICANNに登録されているものと実態が一致していないとICANN側がそのドメインのIPアドレスをブロックしてしまうという展開だ。このページに表示している画面がドメイン停止表示です。対象のサイトが表示されず、代わりにICANN側の勧告が表示される。タイムリミット内にWhoisの更新を行いなさいと出ていますね。さらに、更新が確認できてから24時間から48...

自動AMP(Accelerated Mobile Pages)化の障害回避 WORDPRESSでAMP表示を最適化する。

2019/12/21

2019/12/23

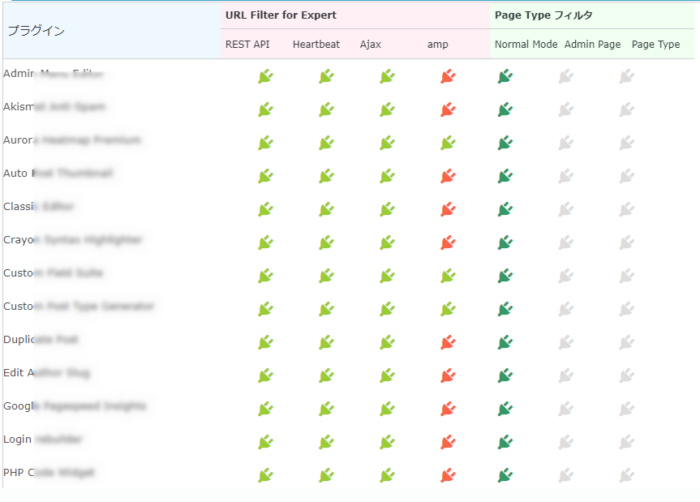

AMPを使うためにWORDPRESSのAMPプラグインを使う方は多いのではないかと思います。その際に発生する問題はAMPプラグイン自体が万能ではないので元のページを完全にAMPできないケースが多いのです。今回はそれを回避するための方法をお話したいと思います。AMPのプラグインはどのような処理を行っているか理解するAMPページはAMP htmlという書式があり、一部HTMLと互換性のタグとオリジナル...

Speed SEOの検証でどの速度を最も重要視しているのか?

2019/12/16

2020/01/06

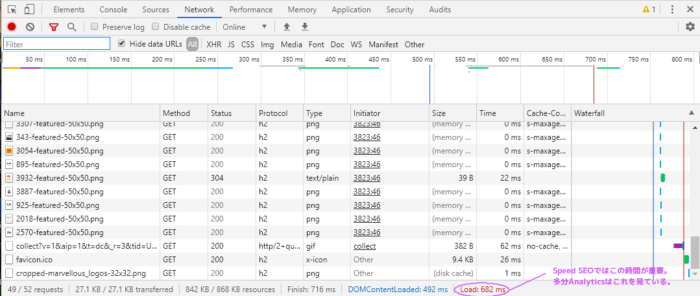

Speed SEOの中で一番重要視するべきと思う速度の箇所について解説します。通常どの種類のWEBブラウザーも名称は多少違いはあるものの検証ツールなるものが存在するのでそれを用いて説明したいと思います。因みに知らない人もいると思いますので「Speed SEO」とはなんぞや?から始めます。Speed SEOはWEBの表示速度を早くしてユーザビリティを高める事が目的です。例えば今ならコンテンツの作り方...

ホームページの高速化手法 GZIP圧縮、コンパイルキャッシュ。画像圧縮、その他コンテンツ圧縮

2019/06/16

2020/01/06

ホームページの高速化の意義現在のグーグル検索順位を決定する基準の一つにホームページの高速表示は不可欠だ。表示が遅くて待たせることはユーザビリティとして適切ではないとグーグルは考えている。その他にも見た目のデザインやコンテンツの確かさ、有益な情報が入っているかが重要な順位を決める要因になりうる。ホームページ高速化の優先順位とりわけSEOとして考えていくなら第一にホームページの表示速度が重要で尚且つ、...